Vous êtes nouveau dans le domaine ou vous êtes un expert, vous allez lancer votre 1er test ou vous réalisez des A/B tests tous les jours ; ou bien vous cherchez encore à découvrir de nouvelles choses autour de cette notion…

L’équipe DataMa a rassemblé pour vous ses experts A/B tests pour répondre à toutes vos questions les plus pointues. Que ce soit sur le nombre, la durée, la méthode, le découpage du trafic ou encore la significativité de ces tests, toutes les réponses que vous cherchez sur les A/B tests sont là ! Guillaume, decision scientist depuis plus de 10 ans et Alex, expert CRO, vous partagent leur expertise.

1 – Il est possible de mener plusieurs tests en même temps sur une même page. VRAI

Cette question revient souvent et beaucoup de gens disent que ce n’est pas possible. Mais mathématiquement, évidemment qu’il est possible de mener plusieurs tests en même temps sur une même page. Dès lors que l’attribution des visiteurs est totalement réalisée au hasard (c’est à dire si ce n’est pas les visiteurs pairs qui vont sur les pages A et A’ et les visiteurs impairs qui vont sur les pages B et B’), que les deux tests sont indépendants et que le volume est suffisant,alors vous pouvez faire tous les tests désirés.

A titre d’exemple, un site comme Homeaway ou Booking réalise plus de 200 tests/mois sur son site internet. Il n’y a pas 200 types de pages différents sur ces sites.

2 – Il est uniquement possible de lancer des tests en 50/50

On peut choisir sa propre répartition !

Seulement, en 90/10 , la durée du test sera contrainte par le trafic minimum (ici 10). Si on n’est pas confiant sur un test ou si on a la volonté de tester doucement au début, on peut débuter par du 90/10.

De aussi bien sur on peut faire du parallèle testing A/B/C/D avec plusieurs variables en même temps (ex 25/25/25/25).

3. Le découpage du trafic doit être stable sur la durée du test

Oui, idéalement, le découpage du trafic doit rester stable dans un test A/B classique. Maintenant il y a quelques exceptions :

- Souvent dans les 2-3 premiers jours du test on lance un ‘ramp-up’ et on commence à 1/99 pour vérifier que les données montent bien et proprement en production avant de passer à 50/50. Cette periode de ‘ramp-up’ ne pourra pas être utilisée dans la lecture des résultats.

- Même si c’est plus compliqué statistiquement, il existe des approches multi armed-bandit (différent de multi-variant testing): les sociétés très avancées en A/B testing utilisent cette approche pour faire varier dans le temps leur répartition / leur trafic split. Il s’agit de partir à 50/50 puis au fur et à mesure qu’une variante est meilleure, je vais déséquilibrer le trafic vers celle-ci pour ne pas perdre de trafic. Attention, c’est réellement plus dur à gérer et à lire statistiquement.

4 – On ne peut avoir la significativité pour une métrique au-dessus de 1 – FAUX

Souvent la question est la suivante : Quelle est la significativité de la variation de mon panier moyen ?

Si j’ai augmenté ma conversion de 2%, mon outil d’A/B testing peut dire si statistiquement c’est parlant.

En revanche si mon panier moyen passe de 320€ à 325€, est-ce significatif ? Pas toujours de réponse des outils d’A/B testing car ils suivent des approches qui font souvent l’hypothèse que la variable suivie est une variable de Bernouilly (la conversion est soit 1 soit 0). Donc pour obtenir la significativité sur le panier moyen ou par exemple sur le revenu/user, il faut simplement revenir à la distribution de base de cette métrique là.

- C’est ce qu’on réalise avec notre outil DataMa Impact. On peut donc lire la significativité sur des métriques qui ne sont pas classiques.

5. La méthode bayésienne est mieux que la méthode fréquentiste – CA DEPEND.

Le marché actuellement a plus tendance à proposer les tests bayésiens, car leur interprétation est plus facile. Pour présenter les résultats à son boss, on pourra simplement dire : « voilà le pourcentage de chances que A soit mieux que B ». Les tests fréquentistes sont un peu plus difficile à interpréter, car on teste la probabilité que ce que l’on observe soit anormale. C’est donc beaucoup plus difficile à expliciter pour un décideur, c’est pourquoi les outils d’A/B tests délaissent un peu cette approche..

- Mais d’un point de vue statistique, chez DataMa on est plus à l’aise avec l’approche fréquentiste pour lire les résultats de significativité, donc on fait les deux ! Et d’ailleurs il existe d’autres tests…

- C’est ce qu’on réalise avec notre outil DataMa Impact. On peut donc lire la significativité sur des métriques qui ne sont pas classiques.

6. Tous les sites devraient lancer des A/B tests – FAUX

En réalité, pas toujours ! Cela n’a pas vraiment de sens pour les trop petits sites <(<10 000 visiteurs/mois) car pour avoir une significativité statistique, on a besoin d’un grand volume de trafic et de données ! Il vaut mieux d’abord faire l’exercice sur les sites de sizing, de durée de test, d’évaluation de la significativité…

Dans un tel cas, pour les petits sites, il vaut mieux regarder ce que font les autres ou faire du user-testing plutôt que de mettre un outil d’A/B test ! Faites de la recherche de marché, ayez la culture d’expérimentation, collectez de la donnée sur vos assets pour voir ce qui marche ou pas…

- Par contre pour les sites plus importants, c’est indispensable.

7. Il faut suivre la significativité même si on l’obtient plus tôt que prévu

C’est une question difficile : a minima, on ne peut pas tourner un A/B test pour moins d’une semaine (notamment à cause de la saisonnalité hebdomadaire). De plus même si les statistiques disent que les résultats sont significatifs, il ne faut pas prendre de décision à moins de 100-200 observations de succès (achat / conversion) en A et en B. La règle de base est donc de se tenir au sizing réalisé avant le test.

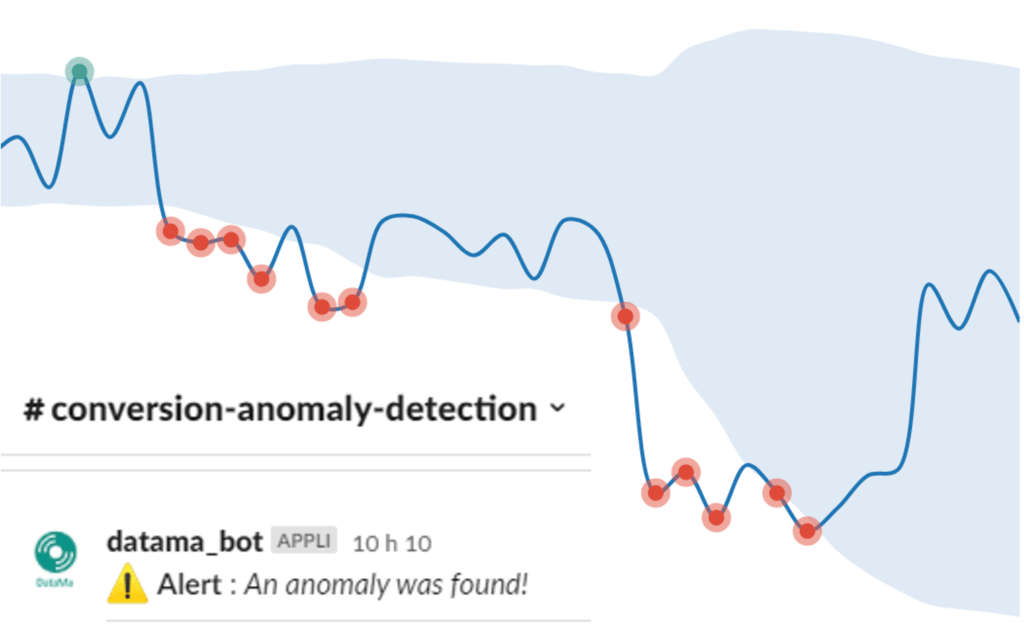

En revanche il est possible avant le test de poser quelques règles business. Par exemple, si l’évolution est drastique et très rapide (ex 20% de chute dès le 1er jour), ou prolongée (perte significative pendant 5 jours d’affilée de conversion), il faut agir pour endiguer cette perte trop importante de business ! Dans ces conditions on peut arrêter le test.

8. Les A/A tests sont inutiles. FAUX

Faux, en réalité c’est une des 1è étapes à mettre en place lorsque l’on va tourner des A/B tests. Il vaut mieux mettre un A/A test en permanence, ne serait-ce que pour vérifier la cohérence des chiffres et des résultats et qu’on observe bien le A/A flat en permanence.

- D’ailleurs sur une période de temps trop courte, on observera régulièrement un A/A négatif ou positif (!) cela montre bien la non-pertinence de données trop peu volumineuses et/ou sur une période de temps trop courte (pour tous les sceptiques de la statistique…).

Si on observe sur une période suffisamment longue des résultats qui seraient significativement à la hausse ou à la baisse, cela pose la question de l’implémentation des outils, du tracking des cookies, des questions de web analytics… toutes les questions fondamentales sur lesquelles beaucoup d’acteurs ont de nombreux challenges. Mais dans ces cas-là, le 1er réflexe doit-être de se demander : est-ce que tu as tourné un A/A test pour vérifier que tes web analaytics étaient bien alignés ?

Tourner un A/A test d’un point de vue technologique permet d’être sûr que les outils technos sont bien alignés, de voir la différence entre la connexion donnée de leurs outils d’AB test et leurs outils d’analytics… Lancer un A/A test devrait être obligatoire lorsque tu intègres un nouvel outil ou pour réaliser un « health check-up », tous les 6 mois pour s’assurer que les outils sont opérationnels et alignés.